Avant de suivre les performances de votre site et son positionnement sur les moteurs de recherche, il est très important de vous assurer que celui-ci est tout d’abord bien lu par le robot de Google et qu’il est donc bien indexé. Cela est obligatoire pour espérer apparaître dans les résultats de recherche et donc générer des visites.

Noel Patel, co-fondateur de KISSmetrics, a publié récemment sur le site de Search Engine Journal, 13 raisons qui pourraient être à l’origine d’une mauvaise indexation (voir d’une non-indexation) de votre site par Google. L’indexation est la porte d’entrée de votre site aux moteurs de recherche et c’est pourquoi nous vous proposons une traduction et un complément d’explications sur ces différents points.

1/ Les problèmes qui empêchent l’indexation

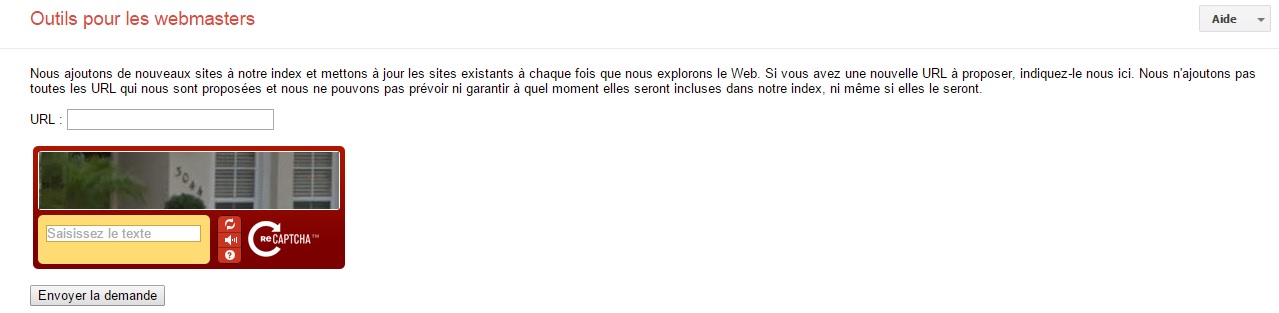

1.1/ Google ne trouve pas votre site tout neuf

Si vous avez publié votre site aujourd’hui ou il y a quelques jours et qu’il n’apparait pas encore sur les moteurs de recherche, cela est tout à fait normal. Ce « problème » peut être classique pour les nouveaux sites, Google pouvant mettre plusieurs jours avant de les répertorier. Si cela persiste, effectuez une soumission manuelle à Google. Cela vous permet de prendre les devants et d’annoncer votre présence au moteur de recherche.

Il faut également bien vérifier que votre fichier de sitemap.xml a bien été créé et est accessible. Ce dernier facilite le travail d’indexation des moteurs de recherche.

Petite astuce : si vous avez un compte Twitter, tweetez le lien de votre page d’accueil. Google observe visiblement les tweets et votre site peut être indexé plus rapidement qu’avec le formulaire de soumission.

1.2/ Un fichier htaccess bloque le site

Le fichier htaccess fait partie intégrante d’un site web et est présent sur votre serveur pour le rendre accessible au World Wide Web. C’est un fichier de configuration des serveurs HTTP Apache.

Parfois, il peut être nécessaire de protéger l’accès à un répertoire sur un serveur web pour éviter que n’importe qui puisse y accéder. Pour cela un bout de code est placé dans le fichier .htaccess qui permet de bloquer l’affichage d’une page en obligeant la saisie d’un login et d’un mot de passe : htpasswd. Ce fichier envoie un code HTTP 401 (« une authentification est nécessaire pour accéder à la ressource ») aux robots des moteurs de recherche leur indiquant de ne pas indexer le site dans son intégralité.

Vérifiez donc la contenu de votre fichier htaccess pour éviter les soucis d’indexation.

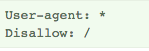

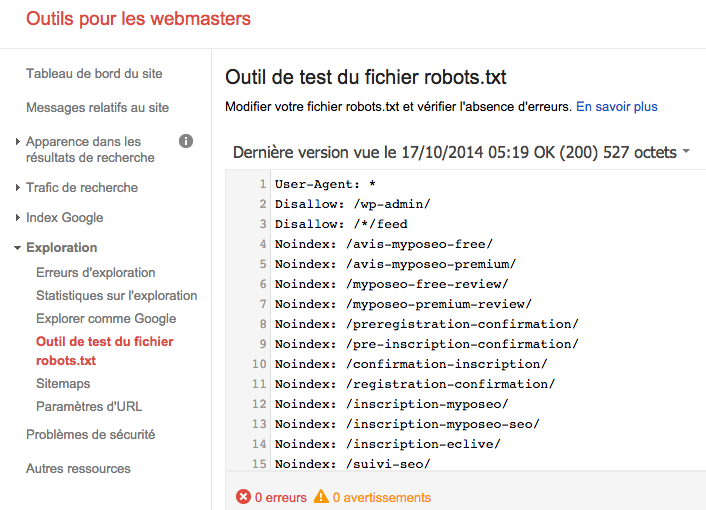

1.3/ Le fichier Robots.txt bloque votre site

Une autre des raisons de la non-indexation de votre site est que celui-ci est peut être bloqué par votre protocole d’exclusion de robots via le fichier robots.txt. Il s’agit d’un fichier texte utilisé pour interdire l’accès à une ou plusieurs pages de votre site aux robots des moteurs de recherche. Celui-ci est placé à la racine d’un site et peut donc bloquer l’exploration de votre site par le Google bot (robot d’exploration web de Google).

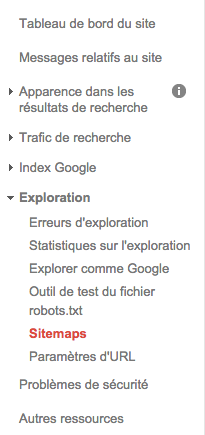

Pour corriger cela vous pouvez vérifier dans votre compte GWT l’état de votre fichier robots.txt et ainsi le modifier.

Pour apprendre comment rédiger votre fichier robots.txt rendez-vous sur le tutoriel de robots-txt.com.

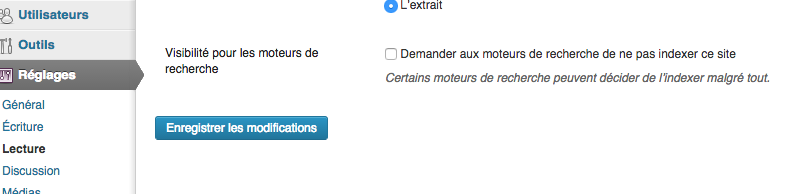

1.4/ WordPress : case de non-indexation par les moteurs de recherche cochée

De très nombreux sites web utilisent aujourd’hui le moteur de WordPress. Lors de la création d’un site sous WordPress vous pouvez cochez dans les réglages un paramètre qui aura pour effet de modifier le fichier robots.txt. Vérifiez bien que cette case est décochée dans votre back office afin de votre site puisse être indexé.

1.5/ Vos URLs sont bloquées par une balise META

Il est possible d’empêcher une page de s’afficher dans les résultats de recherche Google en incluant une balise Meta noindex dans son code HTML. Ce code est à placer entre les balises <head> </head> de votre site, il informe les moteurs qu’il ne faut ni indexer ni suivre les liens de la page.

<META NAME=”ROBOTS” CONTENT=”NOINDEX, NOFOLLOW”>

Il faut donc bien vérifier que vous n’avez pas les attributs noindex, nofollow sur une page ou plusieurs pages de votre site.

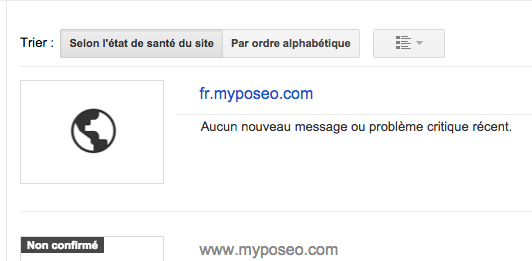

1.6/ Site indexé sous www.

Le premier point important est le sous-domaine sous lequel votre site web a été créé. Beaucoup de sites sont par défaut hébergés sur le sous-domaine « www » et il est trop souvent oublié que http://myposeo.com n’est pas la même adresse que http://www.myposeo.com.

Pour que votre site soit accessible sur les deux adresses, il faut mettre en place une redirection avec un fichier .htaccess par exemple de http://myposeo.com vers http://www.myposeo.com. Pour cela nous vous invitons à lire la démonstration faite sur blogmotion afin de comprendre comment.

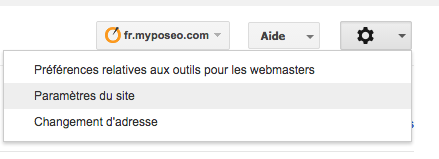

Pour vous assurer ensuite que vous avez bien configuré un accès à votre site via ces deux URLs il faut vous rendre dans votre compte Google Webmaster Tool (GWT) et ajouter ces deux domaines pour qu’ils soient tous les surveillés :

Dans les paramètres de GWT, vous pouvez ensuite choisir le domaine préféré pour l’accès à votre site. C’est ce domaine (ou plutôt sous-domaine) qui sera choisi par Google pour l’affichage de votre site dans le moteur de recherche.

2/ Les problèmes qui nuisent à la bonne indexation ou ré-indexation

2.1/ Vous n’avez pas mis en place de fichier sitemap.xml

Ne pas avoir de sitemap.xml peut être à l’origine d’une mauvaise indexation de votre site par Google. Ce protocole permet d’indiquer les pages d’un site web qui doivent être explorées par les robots des moteurs de recherche. Ainsi des directions sont données à Google des pages présentes dans l’intégralité de votre site. Il faut donc penser à créer et à envoyer un fichier sitemap via GWT.

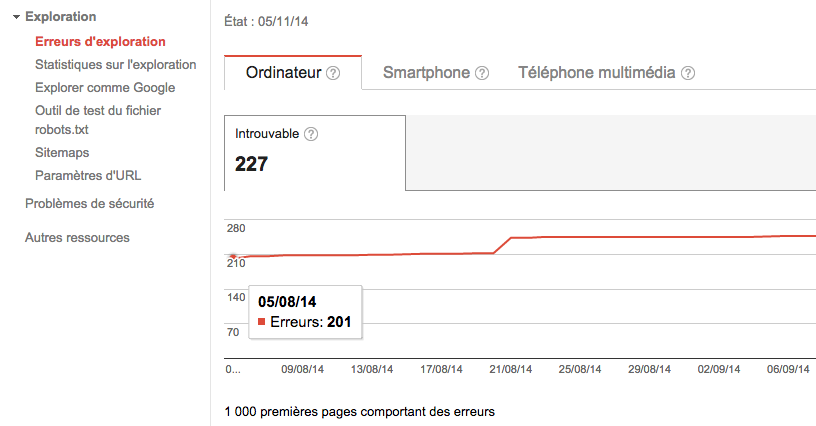

2.2/ Vous avez des erreurs de crawl

Les robots des moteurs de recherche lisent votre site et « sautent » de liens en liens pour continuer à explorer celui-ci. Parfois ils se retrouvent donc dans des impasses ou sur des liens renvoyant vers des pages inexistantes ou déplacées. Votre site a alors une multitude d’erreurs de « crawl » (comprenez lecture) qui sont des erreurs au niveau des URLs. A l’aide de votre compte GWT, vous pouvez les identifier. Sélectionnez votre site puis aller dans erreurs d’exploration. Cette page fournit le détail des URLs que Google ne peut pas explorer ou pour lesquelles un code d’erreur HTTP s’affiche.

Il peut être ensuite important de supprimer les liens de votre site pointant vers des pages inexistantes et/ou penser à rediriger les pages qui n’existent plus vers des pages de substitution. N’hésitez pas pour cela à télécharger des outils gratuits de crawl comme Xenu (pc) ou Integrity (mac) qui vous permettrons de détecter encore plus en profondeur les erreurs et à lire ce tutoriel sur les redirections proposé par Webrankinfo.

2.3/ Du contenu similaire ou dupliqué (duplicate content)

Il arrive que de multiples pages d’un même site proposent le même contenu, c’est ce que l’on appel la duplication de contenu (duplicate content). Cela génère des répétitions au niveau des résultats de recherche que Google tente d’éliminer. Si Google rencontre trop de contenus similaires, il peut ainsi ralentir sa fréquence de crawl, voir exclure du site de l’index.

Pour corriger ce problème, il faut sélectionner la page à garder et renvoyer les autres vers celle-ci en utilisant une redirection 301. Les internautes et les moteurs de recherche seront redirigés vers la bonne page.

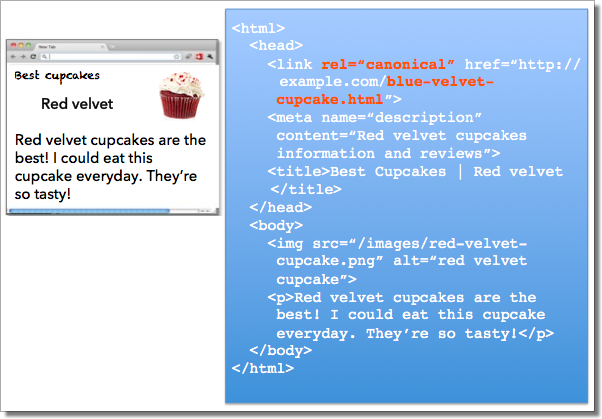

Remarque : Il existe des balises « canonical’‘ pour lutter contre le phénomène de « duplicate content ». En effet, si vous voulez définir une URL favorite à utiliser pour accéder à un contenu, vous pouvez en informer les moteurs de recherche. Il faut baliser la page canonique avec un élément « link » rel=’canonical’.

Pour en savoir plus sur la balise canonical n’hésitez pas à consulter l’article du support de Google sur les URL canonical.

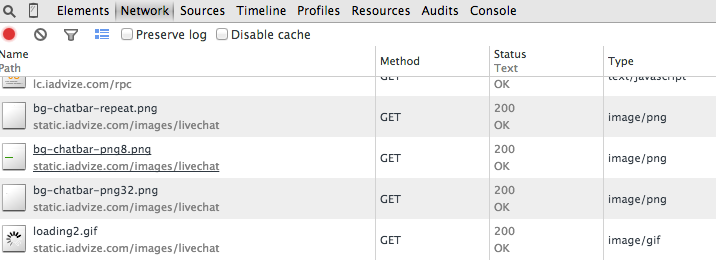

2.4/ Problèmes avec AJAX/JAVASCRIPT

Lorsque les moteurs de recherche peinent à lire le javascript et lorsqu’ils sont bloqués, il s’arrêtent. Dans ce cas, il est impossible de crawler tout ce qui se situe après votre script ( la page, le menu, les autres pages…). Si vous n’avez pas parfaitement configuré vos pages JavaScript, Google peut donc arrêter de lire les données de vos pages et donc limiter l’indexation du site. Pour vérifier cela n’hésitez pas à ouvrir un outil de navigateur type Firebug ou même l’outil natif de Google Chrome pour surveiller le temps de chargement de votre page dans l’onglet « Network » :

2.5/ Chargement continu ou beaucoup trop lent

Le temps de chargement de vos pages peut avoir un impact très important sur les robots, comme nous l’avons précisé dans le point précédent. Si Google n’arrive pas à accéder aux différentes pages de votre site, il ne peut pas se mettre « en pause » et attendre. Au contraire, il risque de quitter votre page et continuer son chemin pour aller crawler les autres sites concurrents. Une page qui se « charge » vite peut être indexée beaucoup plus rapidement et peut contribuer à un meilleur référencement.

De nombreux outils vous permettent de tester les temps de chargement de vos pages comme GTmetrix ou l’extension Yslow, voici d’ailleurs un article sur le blog de SEOmix qui traite de ce sujet.

Remarque : On considère qu’un temps de chargement est raisonnable quand il ne dépasse pas 2 à 3 secondes.

2.6/ Problème avec votre serveur

Google peut avoir les mêmes difficultés à lire les pages de votre site si votre serveur ne peut répondre aux demandes effectuées par le robot pour accéder à l’information. Pour corriger cela, faites en sorte que votre serveur soit solide et puisse supporter le trafic. Pour vous assurer que votre serveur est toujours accessible vous pouvez par exemple utiliser le très bon service gratuit Pingdom qui vous alerte en cas d’inaccessibilité de votre site.

2.7/ Votre site a été désindexé ou pénalisé

« Cher propriétaire ou webmaster du site …, Nous avons constaté que certaines pages de votre site semblent faire appel à des techniques contraires aux Consignes Google aux webmasters. Pour toute question relative à la résolution de ce problème, veuillez consulter notre Forum d’aide pour les webmasters, Cordialement, L’équipe Google chargée de la qualité des recherches. »

Ce type de message est envoyé pour annoncer qu’un site web a été désindexé ou pénalisé de la part de Google. Cela peut arriver si votre site ne respecte pas les critères des filtres Google Panda et Google Penguin. Pour comprendre et analyser la situation de votre site, nous vous conseillons de vos rendre dans les outils webmasters pour consulter les consignes de qualité de Google. Un cas comme celui-ci est assez rare mais tous les sites qui mettent en place une stratégie de Netlinking (liens) ou qui travaillent sur l’optimisation du référencement peuvent être dans le viseur de Google, faite donc attention à ne pas trop en faire !

Conclusion

Vous l’avez compris, pour qu’un site soit présent dans les résultats d’un moteur de recherche il faut qu’il soit indexé dans sa base de données. Dans un premier temps Google doit être capable de le trouver grâce à ses robots et il doit ensuite pouvoir le lire. Si votre site ou certaines pages de votre site ne sont pas indexés, vous devriez maintenant comprendre pourquoi. Vous avez à présent tous les éléments pour analyser votre site et faire en sorte qu’il soit bien référencé et positionné !

Alexandre Sigoigne

CEO et co-fondateur de Myposeo, je suis passionné par les données, le marketing, l'analytics et l'innovation.